目で指でケータイをコントロール――“カラダインタフェース”最新事情:神尾寿の時事日想・特別編

NTTドコモが4月10日、次世代モバイル通信技術である「スーパー3G」の実験環境を公開した(参照記事)。これは報道関係者向けとしては初となるデモンストレーションであり、その模様は別記事に詳しく書いたとおりである。

このスーパー3Gの公開実験に合わせて、ドコモが取り組む先端研究の一部も見ることができた。なかでもUI(ユーザーインタフェース)に関する研究は、今後、ケータイを始めとする様々な機器の操作に応用されていきそうだ。

そこで今日の時事日想は特別編として、ドコモの国内最大の研究開発拠点「NTTドコモ R&Dセンタ」で公開された最新のUI研究についてレポートしていく。

目の動きで操作する。視線インタフェース

“目は口ほどにものを言う”とよく言うが、実際のところ目は我々が考えている以上に大きく的確に動くものだ。この視線の動きをデジタル機器の操作に活用しようというのが、視線インタフェースという分野である。

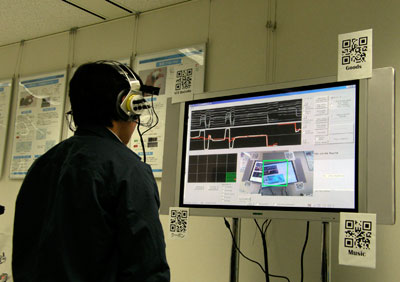

ドコモが公開した視線インタフェース技術のシステムは、「ヘッドホン型視線検出インタフェース」という名称で、眼球の動いたときに体内に発生する微弱な電気を測定して“目の動き”を検知する。実験用システムではヘッドフォンの耳当て部分に電極を内蔵し、視線の動きを検知。さらにヘッドフォン横に設置されたカメラが、目の動きに合わせて方向を変えるというものだった。

実際のサービスを想定した実験では、複数のQRコードを被験者が「見る」と、そのQRコードに応じたコンテンツや広告が表示されるデモンストレーションを実演。これにより「例えば、電車の(中吊り)広告などに視線を向けると、それ(見たモノに)あわせたコンテンツがダウンロードできるサービスなどが実現できる」(技術説明員)という。

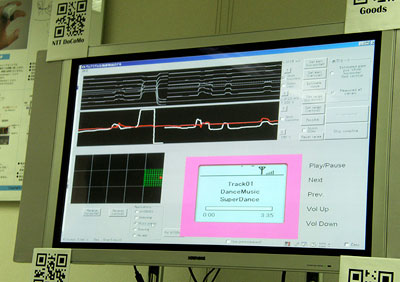

また、視線認識以外の用途として、眼球の動きでデジタル機器の操作を行う実験も紹介。被験者が眼球を動かしたり、回したりすることで、ポータブルオーディオの再生や音量調節ができる様子を紹介した。

「(ヘッドホン型視線検出インタフェースでは)視線検出に電極を用いるため、(ユーザーの目の動きを)カメラで映像認識するよりも検出精度が高く、まぶたを閉じていても検出できるというメリットがあります。また、視線の動きを追従する速度も速い。将来的には、いま市販されているコンパクトヘッドフォンサイズまでシステムを小型化したい」(技術説明員)

視線の向いた方向にカメラが向き、QRコードを自動認識するデモンストレーション。写真は右下に視線が向いている状態。ディスプレイ左下、緑の格子の中にある赤い点が視線位置。右下に視線が入っていることが分かる

視線の向いた方向にカメラが向き、QRコードを自動認識するデモンストレーション。写真は右下に視線が向いている状態。ディスプレイ左下、緑の格子の中にある赤い点が視線位置。右下に視線が入っていることが分かる“目の動き”を読み取るシステムは、クルマの安全走行支援システムとしての研究開発は以前から行われてきた。まばたきの速度や眼球の動きから、“眠気”や“居眠り”を検知する技術はすでに実用化段階に近づいており、今年2月に発表されたトヨタ自動車の新型「クラウン」(参照記事)ではドライバーモニターカメラでまぶたの開閉状態を環視するシステムが投入されている。

しかし、これらは目の動きを読み取ってシステム側が“状態把握をする”ためのパッシブなものであり、今回、ドコモが公開したヘッドホン型視線検出インタフェースのように、よりアクティブにデジタル機器の操作やサービスの利用に使おうというものではない。

最近では、街中の広告や地図案内板がネットサービスと連携する例が増えているが、これらの認証やアクセスに「ケータイを取り出し、操作する」のは面倒な場合も多い。まだ開発段階ではあるが、“見るだけ”で操作ができる視線インタフェースの応用性は高そうである。

指の動きから骨伝導まで、身体すべてがインタフェース

ドコモは以前から身体を使ったインタフェース開発に熱心であり、NTTドコモ R&Dセンタの展示ホール「WHARF」ではすでに発表済みの技術も体験できる。

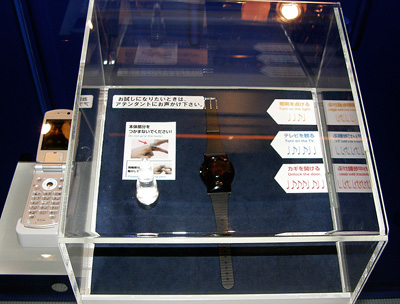

例えば、その1つがウェアラブルコントローラ「UbiButton」だ(参照記事)。これは指先を軽く触れあわせた時の特定周波数の衝撃を検知し、機器のコントロールに応用したもの。展示ペースでは、オーディオコントロールや照明のオン/オフ、ドアの鍵開閉などを指先を触れあわせるリズムによってコントロールするデモンストレーションが行われていた。

このUbiButtonをさらに発展させた「Yubi-Wa」では(参照記事)、同じく指先を触れあわせるリズムでコントロールができるほか、骨伝導技術を内蔵。人差し指を耳穴に密着させると、骨の振動から音が伝わる。本体には小型マイクもあるので、これだけで通話が可能だ。筆者も実際に試したが、音ではなく骨伝導で相手の声が聞こえるので騒音環境下でもクリアーな通話が可能。指の接触検知もきちんと行われていた。

ほかにも、WHARFでは人体を導体として通信する「人体通信」(参照記事、写真)や、スピーカーから発する音や音楽の中にデータを内包させる「音響OFDM」(参照記事)などが展示されていた。

補完型UIという考え方

今回、ドコモが公開した視線検出インタフェースを筆頭に、これら“体を使うインタフェース技術”が発展途上であることは確かだ。いくつかは筆者自身も試したが、まだ違和感を感じるレベルではあるし、技術上の課題が残されているものもある。

しかし、その一方で、現在の高度化し多様化する情報機器の操作体系が、「キーボタン」や「タッチパネル」の進化や活用だけではまかないきれなくなっていることも確かだ。今後は、GPSやモーションセンサー、音声認識などをメーンのUIを補完するUIとして使う手法が拡がるだろう。筆者はこれを補完型UIと定義している。

今回、紹介した身体インタフェースの技術群も、単体では普及や利用促進が難しくても、他のUIと組み合わせて補完的に使うならば有用なものになる。UIの進化の中で、身体インタフェースの活用は興味深いテーマになりそうだ。

関連記事

神尾寿のMobile+Views:ドコモのスーパー3Gに見た「モバイルの近未来」

神尾寿のMobile+Views:ドコモのスーパー3Gに見た「モバイルの近未来」

NTTドコモが4月10日、報道関係者にスーパー3Gの実験環境を公開した。その通信速度は、実験環境とはいえ100〜240Mbps程度を記録。スーパー3Gに、さらに拡大し、可能性が広がる「モバイルの近未来」を見た。 ワイヤレス・テクノロジー・パーク2006:ドコモの“指輪”ハンドセット、製品化の課題は

ワイヤレス・テクノロジー・パーク2006:ドコモの“指輪”ハンドセット、製品化の課題は

ドコモは、CEATEC JAPAN 2005に出展して注目を集めた“指輪型”ハンドセットを出展。製品化に向けた課題を聞いた。 CEATEC JAPAN 2005:ドコモ“指輪”型携帯電話

CEATEC JAPAN 2005:ドコモ“指輪”型携帯電話

指にはめた“指輪型”携帯電話ハンドセットは骨伝導スピーカー内蔵。耳穴に指を差し込むことで音を聞くことができる。“指パチ”による操作も可能になっている。 WIRELESS JAPAN 2004:“指パチ”で操作〜ドコモ、時計型の「UbiButton」

WIRELESS JAPAN 2004:“指パチ”で操作〜ドコモ、時計型の「UbiButton」

身体に伝わる衝撃を感知することで、完全片手操作を実現するデバイスをドコモが開発。“指パチ”で家電機器の操作などが可能になるほか、身体に触れるさまざまな機器への組み込みを検討している。 CEATEC JAPAN 2007:ドコモ、「人体通信」をデモ──自分の体を通信に活用

CEATEC JAPAN 2007:ドコモ、「人体通信」をデモ──自分の体を通信に活用

CEATEC JAPAN 2007のNTTドコモブースに「人体通信」なる技術とその活用提案例が展示されている。体内に微弱な高周波の電気信号を通し、自分の体を経由して送受信機器間で通信するものだという。 ワイヤレスジャパン2006:“音のQRコード”音響OFDM技術をデモ

ワイヤレスジャパン2006:“音のQRコード”音響OFDM技術をデモ

携帯に音を「聴かせる」と、URLを取得できる――NTTドコモが開発中の「音響OFDM」技術のデモを、ドコモブースで体験できる。

Copyright © ITmedia, Inc. All Rights Reserved.

アクセストップ10

- 「楽天ペイ」「楽天ポイントカード」「楽天Edy」アプリを統合 “史上最大級のキャンペーン”も実施 (2024年04月18日)

- 「ポケモンGO」でアバターの髪形や体形を変更可能に 早速試してみた率直な感想 (2024年04月18日)

- 新たな縦折りスマホがDOOGEEから登場 タフネスの次は折りたたみだ (2024年04月18日)

- MVNOが成長するのに“足りていないこと” 「格安スマホ」激動の10年を振り返りながら議論 (2024年04月19日)

- 最新のXperia発表か ソニーが「Xperia SPECIAL EVENT 2024」を5月17日に開催 (2024年04月17日)

- 楽天モバイル通信障害が「ランチタイムを直撃」も現在は復旧 突然の「圏外」表示に慌てる人続出 (2024年04月19日)

- ドコモ、Visaのタッチ決済が使える指輪「EVERING」を販売へ 充電は不要、5気圧防水に対応 (2024年04月19日)

- ライカの新スマホ「Leitz Phone 3」を試す 最上級のスペックに表現力の増したカメラが融合 (2024年04月19日)

- iPhone 13/13 ProやiPhone 14 Proの整備済製品がセールに:AmazonスマイルSALE (2024年04月19日)

- 「改正NTT法」が国会で成立 KDDI、ソフトバンク、楽天モバイルが「強い懸念」表明 (2024年04月17日)