| リビング+:ニュース | 2003/04/15 23:50:00 更新 |

ウワサの“聖徳太子ロボ”を見てきました

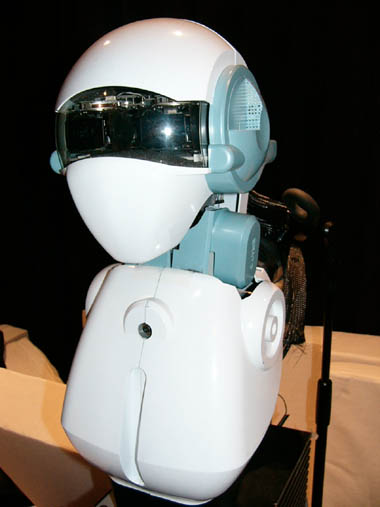

北野共生システムプロジェクトのヒューマノイド「SIG」(シグ)は、通称“聖徳太子ロボ”と呼ばれている。馬小屋で開発されたわけではない。2つの耳と複数の音声認識エンジンを使い、3人が同時に話したことを理解できる

「日本書紀」によると、聖徳太子は一度に10人が言ったことを正しく聞き分けることができたという。通常、人間が同時に聞き取れるのは2つまでといわれているのだが、さすがはもと一万円札。そして、現代のロボットのなかに、通称“聖徳太子ロボ”と呼ばれるものがある。

科学技術振興事業団ERATO北野共生システムプロジェクトの「SIG」(シグ)は、人間とのコミュニケーションをテーマに開発されたヒューマノイドだ。上半身だけで両腕も作られていないが、ほかのロボットにはない特技を持っている。

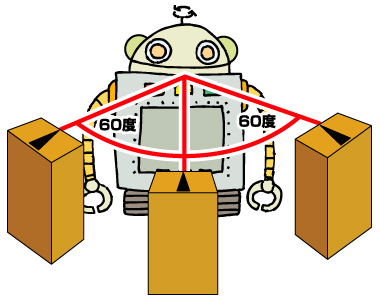

まずはデモンストレーション風景を動画(下の画像をクリック)で見てほしい。SIGの前にあるのは、人に見立てた3つのスピーカー。正面、右60度、左60度の位置に設置されている。

SIGが「すきな数字は?」と訪ねると、3つのスピーカーが一斉に応える。SIGはそれぞれの返事を聞き取り、一人ずつ確認していく。これが“聖徳太子ロボ”と呼ばれる理由だ。一度に複数の人間が発した言葉を理解することができる。

確かに機能はすばらしいが、これが将来のロボット開発にどのように寄与するのか。同プロジェクト共生系知能グループの中臺一博研究員に詳しい話を聞いた。

“音声コミュニケーション”の難しさ

ロボットが人間の生活のなかに入ってきたとき、コミュニケーションの手段として期待されているのが音声。音声認識と音声合成により、あたかも人と人が話すように、ロボットが話の内容を理解して返答する。「鉄腕アトム」や「ドラえもん」にも採用された、人間にとって一番やさしいマンマシンインタフェースだ。

事実、既に販売されているソニー「AIBO」をはじめ、研究開発が進められているロボットのなかにも、“音声コミュニケーション機能”を謳うものが複数ある。しかし中臺氏は、それらのロボットには、いくつかの制約があると指摘した。

「ROBODEXなど展示会のデモンストレーションを見ればわかるように、命令を出す人間がヘッドセットをつけ、大きな声で話している。これは周囲の雑音をカットし、音声認識の対象とする音源を1つに絞るため。でも、実用的な方法とはいえないでしょう?」

例えば人間でも、雑音の多い場所で録音したテープを聞いて、目的の声を聞き分けることは難しいだろう。人間の生活には雑音がつきものであり、外界の雑音、家の中なら掃除機や皿洗いの音など……さまざまなノイズのなかで、ロボットは自分に向けられた言葉だけを聞き取らなければならない。ましてロボットの場合は、自分が発するモーター音が音声認識の妨げとなってしまう。ソニー「AIBO」の音声認識機能が静止した状態でしか動作できない理由もこれだ。

そこで両氏が注目したのが、人間の持つ“アクティブ・パーセプション”(行動と知覚を結びつけること)だ。「たとえば、録音テープから内容を聞き取ることは難しくても、その場にいれば難なく聞き分けられるでしょう? 人間の知覚は常にアクティブで、話しかけられたら相手のほうを向いて声に集中する。ロボットもそうあるべきなんです」

人と同居するロボットは二足歩行が適当といわれるように、人とコミュニケーションをとるには、人と同じアクティブな感覚が必要。言われてみれば、ごく自然な理論に思える。しかし、二足歩行ロボットと違い、こちらの分野は今まで「ほとんど研究されてこなかった」。形として成果が見えにくいうえ、技術的にも難しいためだ。

人間の行動と構造を参考に

両氏は、いくつかの段階を追ってSIGにアクティブ・パーセプションを実装しようと試みた。最初は、ロボットのマイクに入る音から音源の方向を推定する機能だ。

人間の耳を参考にして、SIGには左右2つのメインマイクが装備された。ステレオの音楽が立体的に聞こえるのと同じ理屈で、左右の耳に届く音の強弱から音源の方向を割り出す。

このとき、内部では複数の方角に向けて音声認識エンジンを動かしている。それらの結果を総合し、もっとも確率の高い音声認識結果を導き出すわけだ。同時に、その結果がもっとも明確に認識できた方向に“相手がいる”ことになる。

また、SIGには頭部きょう体の内側にも一対のマイクがあるが、こちらは雑音除去に利用するサブマイクだという。前述のように、ロボットには動作音というノイズが付き物だが、内側のマイクで拾う音はこの動作音が中心だ。つまり、外側のマイクに入る音から、内側のマイクに入る音を差し引けば、外界の音だけを抽出できるというわけだ。

目の代わりとなるCCDカメラは、やはり人間と同じ2つ。この場合、3Dの画像処理を行うわけではなく、これは相手の位置を特定する機能をサポートし、同時に顔認識の追尾性を向上させるため。CCDカメラはパン/チルトのほかズームも可能だ。

SIGに話しかけると、まず音源の方角から相手を推定し、目と関節(SIGには首や腰など4自由度がある)を動かして体ごと相手のほうを向く。耳(マイク)と目(カメラ)から入る情報を総合して音源を追尾し、音声認識と顔認識が互いを補完して知覚を向上させる。聴覚と視覚、そして行動を伴う“アクティブ・パーセプション”を実現したわけだ。

アクティブ・パーセプションは、音声を聞き取りやすくするとともに、“相手と会話する”というシチュエーションを作り出すことができる。そして、認識結果がはっきりしなかったとき、SIGは相手に向かって聞き返す。「すみません。~ですか?」と。

「言葉のやり取りのなかで、認識率を上げることができる。これはロボットだからこそ可能なこと」(同氏)。

「SIG2」プロジェクトでどう進化する?

ここまでの経緯で、SIGは“音の強弱から音源の方向を推定”、“目と耳の情報を統合して知覚を向上”という2つの段階をクリアした。現在では、音源特定の前処理となる“ノイズ除去”や“音の分離”といった行程を加え、さらに知覚の向上を図っている。認識できる言葉は「数字と単語レベル」に限られるものの、“聖徳太子ロボ”のデモンストレーションは、SIGの機能をもっとも分かりやすく示した例といえるだろう。

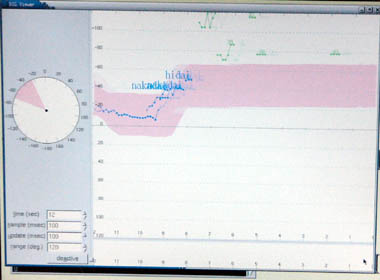

「SIGは、音声認識エンジンを最大51個を同時に動かし、本体の正面から左右60度を限度に、10度単位で17方向までの音源を特定できる。ただし、今のところ音源を推定できるのは水平方向だけだ」(同氏)

当然、次は垂直方向の音源特定を期待したくなるが、中臺氏によると、既に次のプロジェクトが進行中だという。同プロジェクトは京都大学大学院情報学研究科と共同で、「SIG2」(シグツー)を製作している。

ここでも、参考にしたのは人間の構造だった。「人間の耳は、左右対称ではない。これが上下方向の音源も特定できる秘密だ」(同氏)。SIG2には、外形だけでなく外耳道を含む耳の構造を忠実に再現した耳が付けられた。これは実際に人間の耳から型取りしたもので、ABS製の外装にシリコン皮膜を被せている。

さらに、下半身には台座が取り付けられ、SIG2自身が動き回れるようになった。関節は4自由度と変わらないものの、今回からは首も左右に回る。一般的な“ヒューマノイド”のイメージにどんどん近づいていくようだ。

「人間の構造はわかっている。それを再現すれば、同じことができるはず。CPUの性能もどんどん上がっているから、あとはソフトウェアの仕事でしょう」。

中臺氏は、人間がやっていることを工学的に解明し応用することが、ヒューマノイド研究の近道だという。なお、1998年から5年計画で行われてきたSIGのプロジェクトは間もなく一段落。今後は京都大学に移管され、奥乃教授が中心となって研究が進められる見通しだ。

歴史一口メモ:聖徳太子は何人と同時に話ができた?聖徳太子が複数の人の話を同時に聞き取ることができたことはよく知られているが、その人数は書物によってまちまち。「日本書紀」では10人だが、「上宮聖徳法王帝説」によると8人。「聖徳太子伝暦」では、なんと「11歳のときに36人のこどもが一度にいった言葉をすべて理解した」と記されているからわからない。わからないので、ここでは「ベストエフォートの最大36人」としておく。がんばれSIG。 |

関連記事

![]() ROBODEX 2003:PINO、“ver.2”でマッチョに

ROBODEX 2003:PINO、“ver.2”でマッチョに

![]() ヒューマノイド“光化”計画

ヒューマノイド“光化”計画

![]() ロボット社会の伝道師──その名は「PINO」

ロボット社会の伝道師──その名は「PINO」

![]() “中”は村田です――CEATECで話題の人型ロボット「Morph」

“中”は村田です――CEATECで話題の人型ロボット「Morph」

関連リンク

![]() 北野共生システムプロジェクト

北野共生システムプロジェクト

![]() 京都大学

京都大学

[芹澤隆徳,ITmedia]

モバイルショップ

最新スペック搭載ゲームパソコン

最新スペック搭載ゲームパソコン

高性能でゲームが快適なのは

ドスパラゲームパソコンガレリア!

最新CPU搭載パソコンはドスパラで!!

最新CPU搭載パソコンはドスパラで!!

第3世代インテルCoreプロセッサー搭載PC ドスパラはスピード出荷でお届けします!!